样本失衡问题

目录

问题

在机器学习中,我们经常碰到一些样本比例分布不均衡的情况,例如考公上岸比例就达到了100:1. 针对这种正负样本严重失衡的模型,如何做出一些应对处理就显得很重要

采样—让样本均衡

既然样本失衡了,那么久通过欠采样,或者过采样来均衡一下样本。

这个办法不是万能的

修改损失函数

loss损失函数可以修改各类别的损失函数权重

其他

以上办法不是万能的,例如图神经网络中,采样法效果就不是很好。

关于指标选取

既然样本比例失衡了,我们在训练中如何选取最好的模型的指标就需要灵活变化。

如果一味的选取准确率,那么如果样本失衡严重,样本整体的准确率依然会很高,但是这很有可能是样本什么都没学到,全部分为了一类。

先科普RUC曲线与AUC值

|

|

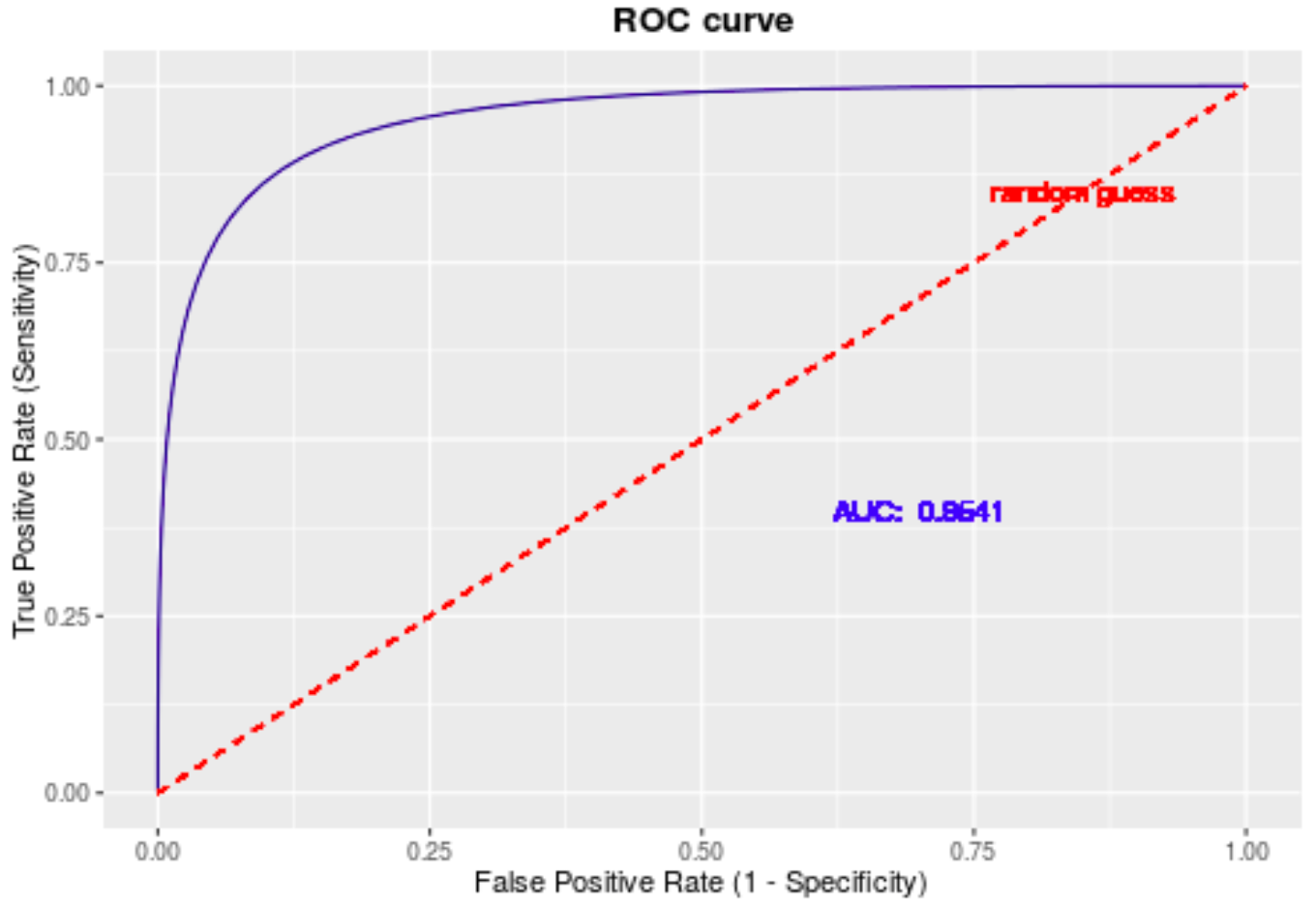

Area Under roc Curve(AUC):顾名思义,AUC的值就是处于ROC 曲线下方的那部分面积的大小。

ROC曲线有个很好的特性:当测试集中的正负样本的分布变化的时候,ROC曲线能够保持不变。在面对正负样本数量不均衡的场景下,ROC曲线(AUC的值)会是一个更加稳定能反映模型好坏的指标。